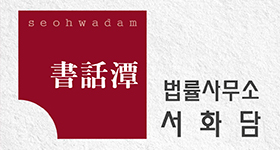

왼쪽부터 손영준(박사과정), 소연경(박사과정), 박찬우(석사과정), 서울대학교 데이터사이언스대학원 교수, 이재진(연구책임자), 김진표(박사과정), 석지헌(박사과정), 조경제(박사과정), 박종원(석사과정), 김종민(박사과정). 사진=한국연구재단

이미지 확대보기국내 연구진이 기존에 공개된 영어 기반 거대 언어 모델(LLM)을 효율적인 방법으로 개량해, 천문학적 비용을 들이지 않아도 ‘고성능 한국어 거대 언어 모델’ 개발이 가능함을 입증했다.

한국연구재단(이사장 홍원화)은 서울대학교 이재진 교수 연구팀이 영어 기반 언어 모델 라마(Llama)를 개량해 한국어에 특화된 언어 모델 Llama-Thunder-LLM과 한국어 전용 토크나이저 Thunder-Tok, 한국어 LLM의 성능을 객관적으로 평가할 수 있는 Thunder-LLM 한국어 벤치마크를 개발해 온라인에 공개했다고 2일 밝혔다.

재단에 따르면 거대 언어 모델(Large Language Model)이란 방대한 양의 텍스트 데이터를 학습해 인간의 언어를 이해하고 생성하는 인공지능 모델이다. 토크나이저란 문장을 언어모델이 이해할 수 있는 단위인 단어, 문장부호 등 ‘토큰’으로 쪼개는 도구다. 텍스트 전처리의 핵심 과정이다.

세계적으로 LLM을 이용한 인공지능 기술이 각광받으며, 국내에서도 한국어 특화 언어 모델 개발에 대한 관심이 증가하고 있다. 하지만 거대 언어 모델 구축에 필요한 데이터가 한정적인데다, 개발에 막대한 비용이 소요돼 지금까지는 대기업과 해외 빅테크 기업을 중심으로 개발이 진행됐으며, 중소 연구기관 및 대학에서는 연구개발이 어려운 상황이었다.

연구팀은 데이터 수집부터 사후 학습까지 언어 모델 학습의 모든 단계를 자체 진행하며 중국의 거대 언어 모델 딥시크(DeepSeek)처럼 제한된 자원으로도 고성능 언어 모델 구축이 가능함을 입증했다.

공개된 영어 모델을 활용했지만, 적용한 기술은 독자적인 모델 개발에 필요한 모든 기술을 포함했다. 이는 연구팀이 고성능의 독자 언어 모델을 개발할 수 있는 기술 역량을 갖추고 있음을 시사한다.

연구팀이 개발한 Llama-Thunder-LLM은 3TB의 한국어 웹 데이터를 수집·전처리해 기존에 공개된 Llama 모델에 연속 학습과 사후 학습 등의 개량 기법을 적용한 한국어 특화 거대 언어 모델이다.

연속 학습(Continual Pre-training)이란 기존 모델에 새로운 데이터를 추가로 학습시켜 특정 능력을 확장하는 과정이다. 사후 학습(Post Training)이란 사용자 질문 응답 등 특정 작업 성능을 높이기 위해 수행하는 추가 미세조정 학습을 뜻한다.

한국어의 문법적 특성을 반영한 토크나이저 Thunder-Tok은 기존 Llama 토크나이저 대비 토큰 수를 약 44% 절약해 추론 속도 및 학습 효율성을 높였다. 연구팀이 자체 개발한 한국어 평가용 데이터셋을 포함한 Thunder-LLM 한국어 벤치마크는 한국어 LLM의 성능을 객관적이고 체계적으로 평가할 수 있는 기반을 제공한다.

이재진 교수는 “이번 연구는 학계도 자주적인 LLM 개발이 가능함을 입증하고 우리나라의 소버린 AI에 기여한 의미 있는 결과”라며, “한국어 기반 LLM 및 토크나이저, 벤치마크 데이터셋을 온라인에 공개하고, 개발 과정 또한 상세히 기술해 누구나 후속 및 재현 연구에 활용할 수 있는 기반을 마련했다”라고 밝혔다.

소버린 AI란 ‘자주적인, 주권이 있는’이라는 의미의 소버린(Sovereign)에 AI를 붙여, 특정 국가가 자국 내에서 독립적으로 운영하고 통제할 수 있는 인공지능 시스템을 의미한다.

이번 연구는 과학기술정보통신부와 한국연구재단이 추진하는 선도연구센터(ERC)사업의 지원으로 수행됐으며, 과학기술정보통신부·광주광역시가 공동 지원한 ‘인공지능 중심 산업융합 집적단지 조성사업’의 장비 지원을 받았다. 연구성과는 누구나 자유롭게 이용할 수 있도록 ‘초거대 AI모델 및 플랫폼 최적화 센터’ 웹페이지에 공개됐다.

전여송 로이슈(lawissue) 기자 arrive71@lawissue.co.kr